一文读懂多家厂商的大模型训练、推理、部署策略

4 月 20 日,第 102 期源创会在武汉胜利举行。本期邀请来自武汉人工智能研讨院、华为、MindSpore、京东云、Gitee AI 的人工智能专家,环绕【大模型竞技与性能优化】主题发表演讲。接下…

大合影 get ✅

披萨和礼物不能少!

接下来进入主题演讲回想环节。可扫描下方二维码、关注 “OSC 开源社区” 视频号,进入 “直播回放” 页面查看完全视频回想:

刘昊:大模型剖析与趋势展望

武汉人工智能研讨院创投转化部总监刘昊带来了《大模型剖析与趋势展望》主题分享。刘昊所在的武汉人工智能研讨院早在 2020 年便开端研讨大模型技巧,2021 年 7 月宣布全球对外宣布了全球第一个千亿参数、笼罩图像、文本、语音的三模态大模型。

刘昊指出,在早前的人工智能技巧研讨中,存在三大问题,一是泛化才能很差,只能解决相似问题;二是模型才能单一,不能解决富文本,或者须要集成多个模型;三是过去一段时光,对数据标注的需求量有点过大了。而大模型恰好可以从这三个方面去解决问题,尤其是在 ChatGPT 涌现之后。ChatGPT 的胜利代表了人工智能很多的下游义务或是下游模型,可以进入流水线式的生,打开了一个人工智能产品化的时期,让技巧人员可以去专注于做底座模型,页让更多人可以参与到人工智能行业中。

此外,大模型催发了存储、算力、运力等多个环节的拉动,通过大模型把很多高低游的产业串到了一起。

从技巧上来说,国内外许多大模型实质上还是沿用之前的 MoE 架构,但大模型做了一次很好的工程化和产品化改革。在模型参数超过 660 亿之后,人工智能中的不可说明性变强,包含才能涌现看起来也是不可说明的。刘昊以为,OpenAI 用了什么方法使得 ChatGPT 的后果这么好,目前还是一个黑盒,但已为知识统一表征和推理、世界认知和建模等问题摸索出了一条途径。

大模型既转变了研讨模式,也转变了服务与开发模式。比如很多公司开端退订大模型的显卡,停滞大模型的开发。最终行业内可能仅存几家大模型工作做底座大模型,而更多的则是行业专业。这也意味着大模型已经进入到了工业化生产的阶段,大模型之上将会形成很多的工具。

目前,紫东太初 2.0 已经升级为全模态大模型,参加三位点云等信息模态。同时,武汉人工智能研讨院也建设了全栈国产化人工智能开放服务平台,把大模型当作底座,安排一站式平台,采取算力 + 平台的新模式,一方面用底座微调数据,一方面可以把平台和算力无缝联合。目前已在全国落地多个 AICC,完成全栈国产化适配,应用高性能普惠算力,深刻融会行业场景,加速大模型应用赋能千行百业。

最后,刘昊也给出了他对大模型发展趋势的 4 大断定:

趋势一:信息技巧应用和创新生态发生巨变,如通过不断豢养数据完成各种智能运动,应用开发进入自然语言编程模式等;

趋势二:重塑再造决策智能的范式,如人机对齐帮助决策;

趋势三:向小型化和范畴化方向发展,在通用认知 AI 基本上迈向专业人工智能;

趋势四:奔向更加通用的人工智能,如大模型与人形机器人交互。

扫码观看《大模型剖析与趋势展望》演讲回放 ⬇️

李树桥:大模型优化技巧在昇腾上的应用与落地

华为软件工程师李树桥带来《大模型优化技巧在昇腾上的应用与落地》主题演讲,从三方面介绍了昇腾在大模型算力方面的特征,包含开源加速库昇腾原生支持、昇腾自研大模型优化技巧、以及基于云原生的生产落地。

首先对于各种开源库的支持,涵盖第三方模型、第三方 AI 框架、第三方加速库、第三方推理服务四慷慨面。比如对于 Pytorch & Torch NPU 的支持,Pytorch 是一款 AI 框架,可分为两大整体,上层是 Pytorch 部分,下层是 Torch NPU。在上层,昇腾通过注册方法,将原生算子和自定义算子注册到 PyTorch,使得 PyTorch 可以在昇腾中有运行,对于下层的 Torch NPU,通过开源贡献,优化 checkpoint、FSDP、Dataloader 等模块的多装备支持才能,实现原生支持 NPU。

此外,昇腾也支持了 onnxRuntime 通用模型框架。包含 Pytorch、TensorFlow、MindSpore 等在内的不同框架可以保留成 onnx 的格局,onnxRuntime 可以去运行调用统一格局。昇腾的原生支持已经支持了 onnxRuntime 库,使得在对接多框架以及易用性上有很大的方便。

模型紧缩方面,DeepSpeed 可对大模型进行紧缩,让其可以更好地安排运行,目前也实现了昇腾的原生支持。

对于供给图像处置,机器学习,视频剖析等功效的盘算机视觉库 OpenCV。昇腾实现后端支持,供给昇腾 NPU 数据构造 AscendMat 和 18 个高频接口,并且多数算子性能晋升 30%。

代码迁移方面。基于 Pytorch 和 TorchNPU,实现了 OpenCLIP 对昇腾的原生支持。可以实现 3 行代码将模型迁移至昇腾装备。

其次在昇腾自研大模型优化技巧方面。昇腾自研 AscendSpeed 大模型加速库。大模型训练是一种非常庞杂的进程,涉及到许多技巧和挑衅,其中大模型训练须要大批的显存资源是一个难题,对盘算卡提出了不小的挑衅。为了在单个盘算卡显存资源不足时,可以通过多张盘算卡进行盘算,业界涌现了相似 Megatron、DeepSpeed 等第三方大模型加速库,对模型、输入数据等进行切分并分配到不同的盘算卡上,最后在通过聚集通讯对成果进行汇总。昇腾供给 AscendSpeed 加速库,使能客户大模型业务快速迁移至昇腾装备,并且支持昇腾专有算法,确保开箱可用。

昇腾还供给了一套比拟完美的工具链 AIT(Ascend Inference Tools),做为统一推理工具链入口,供给客户一体化开发工具,支持一站式调试调优。

最后,在基于云原生的生产落处所面。K8S volcano 调度器支持昇腾装备的亲和性调度。此外 Kubernetes 昇腾装备插件 Kubernetes Device Plugin 可以将其发现的装备个数上报到 Kubernetes 体系中,当装备处于不健康状况时,上报到 Kubernetes 体系中并删除,装备故障后会主动拉起新容器,挂载健康装备,并重建训练义务。当下,Vicuna 昇腾原生支持的 Space 后端已经应用了 Kubernetes Device Plugin。

扫码观看《大模型优化技巧在昇腾上的应用与落地》演讲回放 ⬇️

袁黎江:智启未来 —— 言犀大模型平台

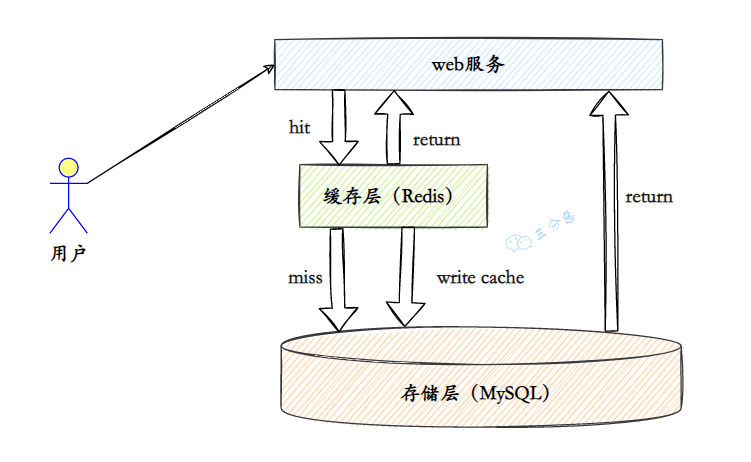

京东云产品总监袁黎江发表了《智启未来 —— 言犀大模型平台》主题演讲。袁黎江介绍,大模型企业级落地有 5 大挑衅:实时性、可说明性、安全可控、庞杂决策、专业性,而落地的症结是在不肯定和动态变更的环境中如何实时作出准确决策并履行。

袁黎江介绍,大模型落地的方法重要有 2 种,一种是 Copilot 的模式,交互关系以人为主导,AI 只是作为一个助手,在某些场景中由 AI 来完成工作,如比如文字内容生成、加工,文生图等。实际上对于企业而言,须要尽可能释放人力。另一种是 Agent 模式,则更适合企业中的庞杂场景,这种模式下人类站在更高维的角度,作为人工智能的 “导师” 或 “教练” 角色,设定目的并监视成果,由大模型去施展推理才能,调用适合的工具和借口,最后给到相应的成果反馈。

大模型在企业中落地所依附的重要技巧也发生了变更,最初的 Pre-train 成本最高、投入伟大;之后 SFT 模式成本下降但是落地后果欠佳;基于向量数据库的检索加强 RAG 模式,后果晋升但仅能局限在知识问答场景中;最终,精通技巧团队更加关注 Agent 模式,可以实现多场景支持。

在京东金融业务中,单纯靠大模型 SFT 或者 LoRA 难以晋升大模型解决实际问题的才能,而是基于 Agent 技巧实现机器应用工具解决业务问题。具体而言是通过 Agent 的方法去懂得用户目的,拆解每一步子义务,在每一步子义务里选择适合的工具,这些工具是京东原有业务的一些接口,最后再联合大模型才能给出反馈。这样对于一些用户庞杂问题的答复则会更精准。

目前,京东言犀大模型全平台已经构建了多层产品矩阵。最底层为资源支持,包含盘算资源、存储资源、高速网络和资源调度。在模型资源层,供给了模型管理训练、数据集加工、模型评测安排等才能。模型资源层之上为智能体构建,关注各类工具的集成。最上层则是应用服务层,适配多个企业场景。

京东言犀大模型全平台具备 6 大功效:资源调度协同,可实现盘算资源的高效管理和调度,确保大模型开发及应用的性能优化和成本掌握;数据管理,针对大模型训练供给管理,支持预训练、微调、强化学习、评测等高效开展;模型训练,通过大模型进行训练和微调让企业拥有定制化模型,进步准确性和相干性;智能体构建,助力企业创立和安排智能体 Agent,与企业现有 IT 体系联合履行庞杂义务;安全合规,确保所有大模型应用都符合安全尺度和法律法规要求;智能应用市场,供给一系列预构建的大模型应用,企业可以直接安排或给予插件体系快速接入。

扫码观看《智启未来 —— 言犀大模型平台》演讲回放 ⬇️

林家桢:大模型 Serverless 推理体系

当下,一些模型方或是平台方会为个人用户供给一些免费的算力用于应用大模型技巧,Gitee.AI 作为大模型聚合平台也在为个人用户供给免费算力。Gitee AI 专家参谋、清华大学高性能盘算所林家桢带来《大模型 Serverless 推理体系》主题演讲。

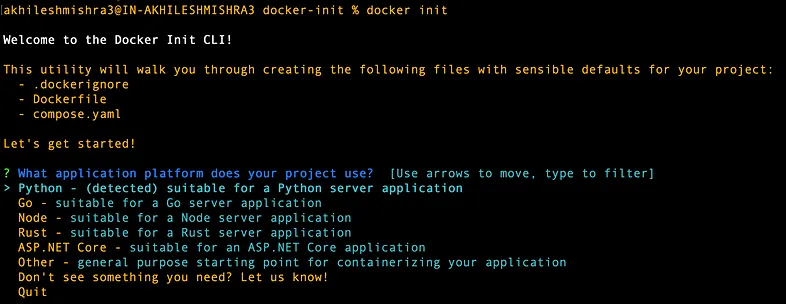

林家桢指出,Gitee.AI 目前聚合了 2000 多个模型,但免费的算力资源有限,因此就须要更加高效地将这些免费算力按需分配给开发者应用,这在当下是一个非常有挑衅性的问题。比如以往应用容器技巧做外部开发时,单个容器的换入换出以及唤醒都非常快速,但是这在大模型时期变难了,模型的唤醒和休眠导致容器的换入换出管理难以同以往的场景一样高效。

而 Serverless AI 具备 4 大优势,包含安排简略、开箱即用,下降算力应用成本,笼罩主流模型,支持多种算力硬件。目前的模型引擎或者说购置、应用算力的方法存在一个问题,即用户程序、模型、推理的芯片全都绑在一个容器上,占住硬件芯片,应用算力服务。而 Serverless 推理引擎整合优化算力资源,通过多个层级的解聚合,下降应用、模型、算力三者间的耦合性,按需分配算力,进步资源应用率。

Serverless 体系架构分为三层,最底层为编译器层,将在容器中加载模型改为 rpc 调用到远端服务的模式,接口没有转变,但是换成了后端的推理,以实现模型和芯片的解聚合。rpc 给到上一层的推理引擎,推理引擎是实际上发生盘算的集群,这个层级则做了数据和算力解聚合。比如假设一个十张卡满足 3000 个模型的调度要求的义务场景,这时没方法在一张卡上固定加载某个大模型,便须要依据要求临时动态高效加载想要的模型,因此把盘算的芯片和模型权重做解聚合,模型放在 TanserGraph 上,这是一个异构的内存体系,可支持实现算力芯片和模型解聚合。在最上层,Serverless 层,则进行应用和推懂得聚合。

Serverless 体系架构的核心才能是异构互联内存,解决模型权重问题。数据中心整机架构存在一些局限性,如资源应用率低、硬件扩大性受限等,解聚合技巧可以将整机架构中各部件物理分别,应用必定互联链接各部件的掌握界面(Control Plane)与数据界面(Data Plane),实现各类资源按需分配、扩容。此外,内存解聚合在云场景下也具备应用优势,包含进步云环境资源应用率和便于满足日益增加的内存资源需求。

但现有分层内存体系不适应解聚合架构下的高硬件弹性,体系扩大性也受限,并且由于体系内部构造限制,现有内存管理接口才能受限。异构互联内存则可以通过硬件拜访统计、可编程策略、页迁移三个环节解决这些问题。以 CPU 为例,对于基于 PEBs 的拜访统计上,支持硬件采集运行程序的访存情形,记载指令、TID、目的地址等,然后按需加载模型权重。

此外,Serverless 体系架构也具备了其他多种才能,如基于 MLIR 的多层次神经网络编译优化技巧,基于用户态隔离技巧的轻量化体系服务机制。Serverless 推理引擎基于两大核心知识产权技巧构建,除此之外也整合了目前各类主流的推理体系优化技巧。

目前,Llama 3 已经上线 Gitee AI。复制下方链接至阅读器,进入平台即可体验(邀请码:llama3):

https://ai.gitee.com/hf-models/shenzhi-wang/Llama3-8B-Chinese-Chat

扫码观看《大模型 Serverless 推理体系》演讲回放⬇️

陈子恒:昇思 MindSpore 大模型症结技巧与计划

MindSpore Research Engineer 陈子恒带来《昇思 MindSpore 大模型症结技巧与计划》主题演讲。陈子恒介绍,在行业中,MindSpore 介于底层芯片硬件与上层行业应用之间。MindSpore 在大模型技巧方面,首先做的是基本层,笼罩了多个底层大模型,在上层则是与行业伙伴构建行业模型。此外,MindSpore 也兼容了国内外多款主流的开源大模型。针对所有大模型,MindSpore 通过 MindFormers、MindPET、MindRLHF 三个基本套件,统一大模型开发、微折衷安排等全流程,实现开箱即用。

针对大模型训练。MindSpore 采取的是基于盘算图的编译器来实现并行策略。输入一张盘算图,MindSpore 的图编译进程会将图依照并行策略进行切分,并在其中主动插入数据的重排算子,来保障多机的并行盘算逻辑与单机一致。通过这种方法,MindSpore 实现了多个层次的优化,包含顶层的主动策略生成,多维度的混杂并行,以及在运行时支持多维存储和异构的优化。

从去年开端,MindSpore 团队也一直在做大模型的并行训练。通常情形下,典范的大模型训练会混杂应用 5 种并行策略,包含数据并行、优化器并行、模型并行、流水并行、重盘算。MindSpore 团队剖析了典范模型在这些并行模式下的耗时情形,发现这里的重要开销在三个方面,包含算子级模型并行的开销、pipeline 并行发生的 bubble、数据并行的拖尾时光。并且当集群范围不断增大,到万卡集群的时候,这些开销的问题会更显著,例如由于 global batchsize 的受限,pipeline 的 bubble 问题会更严重,并且由于通讯域增大,通讯性能会劣化,数据并行的拖尾占比会升高。

对于这些问题,陈子恒也介绍了一些解决方法,比如多副本并行模式隐蔽模型通讯,将数据一分为二,每个数据可以独立的进行盘算和通讯,而多份数据之间的盘算和通讯就可以相互隐蔽了,以此优化算子级模型并行。对于 PipeLine 并行优化,通过 PipeLine Interleave 把 Bubble 下降到 10% 以。

此外针对 MoE 训练时会遇到冷热专家的问题,对于专家热迁移,下降 AlltoAll 通讯量,晋升 MoE 模型训练性能。除了高性能训练,大模型还有一个问题是怎么做策略并行,MindSpore 采取的是主动并行,大模型并行策略调优时光月级可以降为小时级。

安排方面,MindSpore 相当于是 severless 的后端,须要解决的是效能问题。MindSpore 通过火布式并行推理、K-V Cache、动态 seq、continue batch、高性能推理融会算子,构建低时延、高吞吐、支持长序列大模型统一推理框架。训推一体架构,使得训练到推理无缝连接。

接下来,MindSpore 在大模型训练方面的计划涵盖万卡大集群训练性能优化、浓密大模型性能优化、稀少 MoE 大模型性能优化等方面,在大模型推理方面筹划更加深刻研讨大模型训推一体架构、浓密大模型推理加速、稀少大模型推理加速等。

扫码观看《昇思 MindSpore 大模型症结技巧与计划》演讲回放 ⬇️

本期运动回想就到这里啦~